Индексация сайта в поисковых системах является ключевым этапом в поиске информации пользователями. От того, как информация о вашем сайте представлена в поисковиках, зависит её доступность для пользователей при вводе соответствующих запросов.

Основания для ограничения индексации сайта

Существует множество причин, по которым вы можете захотеть ограничить индексацию вашего сайта поисковыми системами. Давайте рассмотрим самые распространенные из них:

- Сайт находится в стадии разработки или модернизации: Если сайт ещё не готов к публичному показу или нуждается в срочных доработках, предпочтительно закрыть его от индексации.

- Сайт предназначен для узкого круга пользователей: В таком случае нежелательно, чтобы сайт был доступен для широкой аудитории.

- Переезд на новый домен или изменение стратегии продвижения: В этом случае может потребоваться временно убрать старый домен из индексации.

Использование файла robots.txt для управления индексацией

Файл robots.txt - это первый шаг в управлении доступом поисковых систем к вашему сайту. Этот файл дает указания поисковым ботам о том, какие страницы индексировать, а какие следует игнорировать.

User-agent: *

Disallow: /

Настройка индексации определенных разделов сайта

Для точечного контроля индексации отдельных страниц или разделов сайта используются специальные настройки в файле robots.txt.

| Отдельной страницы |

User-agent: * Disallow: /contact.html |

| Раздела |

User-agent: * Disallow: /catalog/ |

| Всего сайта, кроме одного раздела |

User-agent: * Disallow: / Allow: /catalog |

| Всего раздела, кроме одного подраздела |

User-agent: * Disallow: /product Allow: /product/auto |

| Поиска на сайте |

User-agent: * Disallow: /search |

| Административной панели |

User-agent: * Disallow: /admin |

Расширенные настройки контроля индексации

Файл robots.txt также позволяет детально управлять индексацией различных типов файлов, включая картинки, скрипты и даже utm-метки.

| Типа файлов | User-agent: * Disallow: /*.jpg |

| Папки | User-agent: * Disallow: /images/ |

| Папку, кроме одного файла | User-agent: * Disallow: /images/ Allow: /images/file.jpg |

| Скриптов | User-agent: * Disallow: /plugins/*.js |

| utm-меток | User-agent: * Disallow: /*utm= |

| utm-меток для Яндекса | Clean-Param: utm_source&utm_medium&utm_campaign |

Исключение изображений из индексации

Если необходимо предотвратить индексацию изображений, можно использовать следующие настройки в robots.txt:

User-Agent: *

Disallow: *.png

Disallow: *.jpg

Disallow: *.gif

Особенности закрытия поддоменов

Для поддоменов обычно применяется отдельный файл robots.txt, который можно найти и отредактировать в их корневых папках:

User-agent: *

Disallow: /

Закрытие сайта через мета-теги

Мета-теги также могут использоваться для контроля индексации как отдельных страниц, так и всего сайта в целом. Вот примеры таких тегов:

<meta name="robots" content="noindex, nofollow"/>

<meta name="robots" content="none"/>

Атрибут “content” имеет следующие значения:

- none - индексация запрещена, включая noindex и nofollow;

- noindex - запрещена индексация содержимого;

- nofollow - запрещена индексация ссылок;

- follow - разрешена индексация ссылок;

- index - разрешена индексация;

- all - разрешена индексация содержимого и ссылок.

Настройка сервера для управления доступом поисковых систем

В некоторых случаях, когда стандартные методы управления доступом поисковых систем к сайту не приносят ожидаемых результатов, вебмастеры могут обратиться к настройкам сервера. Это может потребоваться, например, если поисковые системы продолжают индексировать контент, который должен быть исключен, несмотря на настройки в файле robots.txt. Решение такой проблемы возможно через настройки в файле .htaccess, расположенном на сервере сайта. Ниже приведены примеры директив, которые можно использовать в этом файле для различных поисковых систем:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

SetEnvIfNoCase User-Agent "^Yandex" search_bot

SetEnvIfNoCase User-Agent "^Yahoo" search_bot

SetEnvIfNoCase User-Agent "^Aport" search_bot

SetEnvIfNoCase User-Agent "^msnbot" search_bot

SetEnvIfNoCase User-Agent "^spider" search_bot

SetEnvIfNoCase User-Agent "^Robot" search_bot

SetEnvIfNoCase User-Agent "^php" search_bot

SetEnvIfNoCase User-Agent "^Mail" search_bot

SetEnvIfNoCase User-Agent "^bot" search_bot

SetEnvIfNoCase User-Agent "^igdeSpyder" search_bot

SetEnvIfNoCase User-Agent "^Snapbot" search_bot

SetEnvIfNoCase User-Agent "^WordPress" search_bot

SetEnvIfNoCase User-Agent "^BlogPulseLive" search_bot

SetEnvIfNoCase User-Agent "^Parser" search_bot

Эти директивы позволяют идентифицировать трафик от различных поисковых роботов и применять к ним специфические настройки на уровне сервера, что может быть полезно для более тонкого управления доступом к сайту.

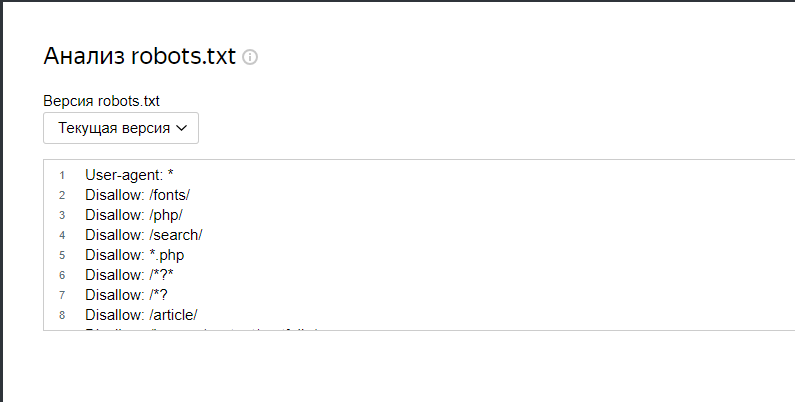

Проверка файла robots.txt на наличие ошибок

После внесения изменений важно убедиться в отсутствии ошибок в файле robots.txt, используя инструменты вебмастера:

- Панель Вебмастера Яндекс: https://webmaster.yandex.ru/tools/robotstxt/

- Google Search Console: https://www.google.com/webmasters/tools/robots-testing-tool

Заключение

Использование этих методов позволит вам эффективно управлять индексацией вашего сайта на Битриксе, что положительно скажется на вашей SEO-стратегии и обеспечит защиту конфиденциальной информации.

Если вы не смогли самостоятельно разобраться в скрытии сайта от индексирования, обращайтесь к нам и мы Вам поможем доработки сайта на 1С-Битрикс.